>[info] **docker仓库:** [https://hub.docker.com/r/sebp/elk](https://hub.docker.com/r/sebp/elk)

[TOC]

## 一、修改mmap计数大于等于262144的限制

~~~

#在/etc/sysctl.conf文件最后添加一行

vm.max_map_count=655360

#并执行命令

sysctl -p

~~~

## 二、下载并运行镜像

~~~

docker run -p 5601:5601 -p 9200:9200 -p 9300:9300 -p 5044:5044 --name elk -d sebp/elk:651

~~~

## 三、准备elasticsearch的配置文件

~~~

mkdir /opt/elk/elasticsearch/conf

#复制elasticsearch的配置出来

docker cp elk:/etc/elasticsearch/elasticsearch.yml /opt/elk/elasticsearch/conf

~~~

## 四、修改elasticsearch.yml配置

* 修改cluster.name参数

~~~

cluster.name: es

~~~

* 在最后新增以下三个参数

~~~

thread_pool.bulk.queue_size: 1000

http.cors.enabled: true

http.cors.allow-origin: "*"

~~~

## 五、准备logstash的配置文件

~~~

mkdir /opt/elk/logstash/conf

#复制logstash的配置出来

docker cp elk:/etc/logstash/conf.d/. /opt/elk/logstash/conf/

~~~

## 六、准备logstash的patterns文件

* `mkdir /opt/elk/logstash/patterns`

* 新建一个`java`的patterns文件,`vim java`内容如下

~~~

# user-center

MYAPPNAME ([0-9a-zA-Z_-]*)

# RMI TCP Connection(2)-127.0.0.1

MYTHREADNAME ([0-9a-zA-Z._-]|\(|\)|\s)*

~~~

>[danger] 就是一个名字叫做**java**的文件,不需要文件后缀

## 七、删除02-beats-input.conf的最后三句,去掉强制认证

~~~

vim /opt/elk/logstash/conf/02-beats-input.conf

#ssl => true

#ssl_certificate => "/pki/tls/certs/logstash.crt"

#ssl_key => "/pki/tls/private/logstash.key"

~~~

## 八、修改10-syslog.conf配置,改为以下内容

* **注意,下面的logstash结构化配置样例都是以本工程的日志格式配置,并不是通用的**

~~~

filter {

if [type] == "syslog" {

grok {

match => { "message" => "%{SYSLOGTIMESTAMP:syslog_timestamp} %{SYSLOGHOST:syslog_hostname} %{DATA:syslog_program}(?:\[%{POSINT:syslog_pid}\])?: %{GREEDYDATA:syslog_message}" }

add_field => [ "received_at", "%{@timestamp}" ]

add_field => [ "received_from", "%{host}" ]

}

syslog_pri { }

date {

match => [ "syslog_timestamp", "MMM d HH:mm:ss", "MMM dd HH:mm:ss" ]

}

}

if [fields][docType] == "sys-log" {

grok {

patterns_dir => ["/opt/elk/logstash/patterns"]

match => { "message" => "\[%{NOTSPACE:appName}:%{NOTSPACE:serverIp}:%{NOTSPACE:serverPort}\] %{TIMESTAMP_ISO8601:logTime} %{LOGLEVEL:logLevel} %{WORD:pid} \[%{MYAPPNAME:traceId}\] \[%{MYTHREADNAME:threadName}\] %{NOTSPACE:classname} %{GREEDYDATA:message}" }

overwrite => ["message"]

}

date {

match => ["logTime","yyyy-MM-dd HH:mm:ss.SSS Z"]

}

date {

match => ["logTime","yyyy-MM-dd HH:mm:ss.SSS"]

target => "timestamp"

locale => "en"

timezone => "+08:00"

}

mutate {

remove_field => "logTime"

remove_field => "@version"

remove_field => "host"

remove_field => "offset"

}

}

if [fields][docType] == "point-log" {

grok {

patterns_dir => ["/opt/elk/logstash/patterns"]

match => {

"message" => "%{TIMESTAMP_ISO8601:logTime}\|%{MYAPPNAME:appName}\|%{WORD:resouceid}\|%{MYAPPNAME:type}\|%{GREEDYDATA:object}"

}

}

kv {

source => "object"

field_split => "&"

value_split => "="

}

date {

match => ["logTime","yyyy-MM-dd HH:mm:ss.SSS Z"]

}

date {

match => ["logTime","yyyy-MM-dd HH:mm:ss.SSS"]

target => "timestamp"

locale => "en"

timezone => "+08:00"

}

mutate {

remove_field => "logTime"

remove_field => "@version"

remove_field => "host"

remove_field => "offset"

}

}

}

~~~

## 九、修改30-output.conf配置,改为以下内容

~~~

output {

if [fields][docType] == "sys-log" {

elasticsearch {

hosts => ["localhost"]

manage_template => false

index => "sys-log-%{+YYYY.MM.dd}"

document_type => "%{[@metadata][type]}"

}

}

if [fields][docType] == "point-log" {

elasticsearch {

hosts => ["localhost"]

manage_template => false

index => "point-log-%{+YYYY.MM.dd}"

document_type => "%{[@metadata][type]}"

routing => "%{type}"

}

}

}

~~~

## 十、创建运行脚本

**`vim /opt/elk/start.sh`**

~~~

docker stop elk

docker rm elk

docker run -p 5601:5601 -p 9200:9200 -p 9300:9300 -p 5044:5044 \

-e LS_HEAP_SIZE="1g" -e ES_JAVA_OPTS="-Xms2g -Xmx2g" \

-v $PWD/elasticsearch/data:/var/lib/elasticsearch \

-v $PWD/elasticsearch/plugins:/opt/elasticsearch/plugins \

-v $PWD/logstash/conf:/etc/logstash/conf.d \

-v $PWD/logstash/patterns:/opt/logstash/patterns \

-v $PWD/elasticsearch/conf/elasticsearch.yml:/etc/elasticsearch/elasticsearch.yml \

-v $PWD/elasticsearch/log:/var/log/elasticsearch \

-v $PWD/logstash/log:/var/log/logstash \

--name elk \

-d sebp/elk:651

~~~

## 十一、运行镜像

~~~

sh start.sh

~~~

## 十二、添加索引模板(非必需)

如果是单节点的es需要去掉索引的副本配置,不然会出现`unassigned_shards`

1. 更新已有索引

~~~

curl -X PUT "http://192.168.28.130:9200/sys-log-*/_settings" -H 'Content-Type: application/json' -d'

{

"index" : {

"number_of_replicas" : 0

}

}

'

curl -X PUT "http://192.168.28.130:9200/mysql-slowlog-*/_settings" -H 'Content-Type: application/json' -d'

{

"index" : {

"number_of_replicas" : 0

}

}'

~~~

2. 设置索引模板

**系统日志**

~~~

curl -XPUT http://192.168.28.130:9200/_template/template_sys_log -H 'Content-Type: application/json' -d '

{

"index_patterns" : ["sys-log-*"],

"order" : 0,

"settings" : {

"number_of_replicas" : 0

},

"mappings": {

"doc": {

"properties": {

"message": {

"type": "text",

"fields": {

"keyword": {

"type": "keyword",

"ignore_above": 256

}

},

"analyzer": "ik_max_word"

},

"pid": {

"type": "text"

},

"serverPort": {

"type": "text"

},

"logLevel": {

"type": "text"

},

"traceId": {

"type": "text"

}

}

}

}

}'

~~~

**慢sql日志**

~~~

curl -XPUT http://192.168.28.130:9200/_template/template_sql_slowlog -H 'Content-Type: application/json' -d '

{

"index_patterns" : ["mysql-slowlog-*"],

"order" : 0,

"settings" : {

"number_of_replicas" : 0

},

"mappings": {

"doc": {

"properties": {

"query_str": {

"type": "text",

"fields": {

"keyword": {

"type": "keyword",

"ignore_above": 256

}

},

"analyzer": "ik_max_word"

}

}

}

}

}'

~~~

**埋点日志**

~~~

curl -XPUT http://192.168.28.130:9200/_template/template_point_log -H 'Content-Type: application/json' -d '

{

"index_patterns" : ["point-log-*"],

"order" : 0,

"settings" : {

"number_of_shards" : 2,

"number_of_replicas" : 0

}

}'

~~~

## 十三、安装IK分词器

查询数据,都是使用的默认的分词器,分词效果不太理想,会把text的字段分成一个一个汉字,然后搜索的时候也会把搜索的句子进行分词,所以这里就需要更加智能的分词器IK分词器了

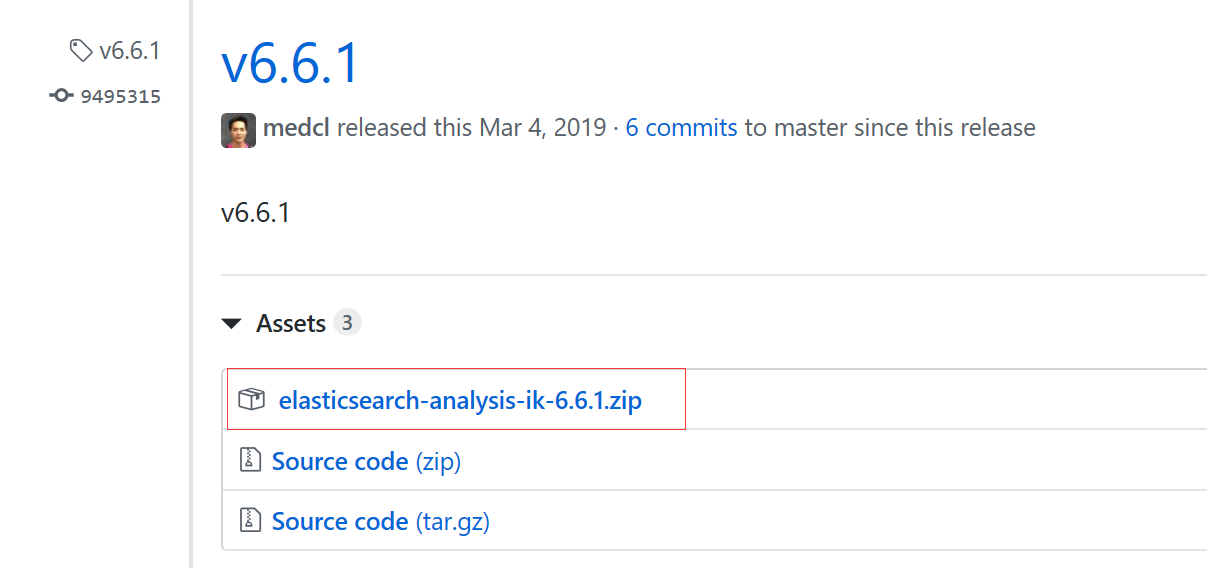

### 13.1 下载

下载地址:[https://github.com/medcl/elasticsearch-analysis-ik/releases](https://github.com/medcl/elasticsearch-analysis-ik/releases)

这里你需要根据你的Es的版本来下载对应版本的IK

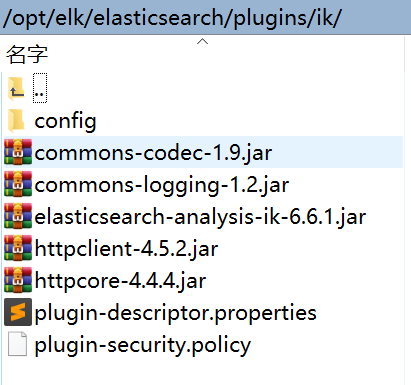

### 13.2 解压-->将文件复制到 es的安装目录/plugin/ik下面即可

完成之后效果如下:

### 13.3 重启容器并检查插件是否安装成功

[http://192.168.28.130:9200/\_cat/plugins](http://192.168.28.130:9200/_cat/plugins)

## 十四、配置样例

链接:[elk配置下载](./elk.zip)

- 微服务介绍

- 软件架构设计

- 系统简介

- 运行环境

- 模块介绍

- 启动部署命令参数

- 打包说明

- 开发说明

- Java8

- 认证理论

- 有网络隔离

- 无网络隔离

- token自动续签设计

- url级权限控制

- 单点登录

- 登录

- 用户名密码(+验证码)登录

- 通过openId获取token

- 通过手机号获取token

- 第三方系统接口对接

- 第三方系统单点登录

- 通用刷新token

- 账号登出接口

- 统一异常处理

- 日志埋点工具

- 审计日志

- yml自定义配置自动提示

- Redis使用

- CacheManager集成

- 搜索中心

- 网关zuul动态路由

- swagger

- 解决开发环境的服务冲突和实例乱窜

- 多租户理论

- 多租户实现

- 分布式锁

- 分布式id生成器

- 分布式事务

- 分库分表sharding-sphere

- 消息队列

- 系统幂等性

- X 实时搜索系统设计

- Spring Cloud性能调优

- 链路跟踪

- JWT的RSA非对称密钥生成

- jdk

- Oracle

- OpenJDK

- Dragonwell

- JVM介绍

- 常见JVM内存错误及解决方案

- JVM分析工具详解

- nexus

- docker

- 安装

- docker-compose安装

- 私有仓库搭建

- 指定数据储存目录

- 添加私有仓库

- 提交拉取镜像

- X 免Dockerfile文件构建项目镜像

- 持续集成部署CI/CD

- Confluence知识管理

- JIRA事务与项目跟踪软件

- Gitlab代码仓库

- Jenkins自动化部署

- SonarQube代码检测

- Rancher容器管理平台

- nacos

- 部署

- Rancher部署nacos

- 注册中心

- 配置中心

- 多环境

- 生产部署方案

- X 通过Nginx来实现环境隔离

- Sentinel详解

- 动态规则扩展

- 在生产环境中使用 Sentinel

- 启动配置项

- X 网关流控

- ELK日志系统和慢查询SQL

- docker安装

- 普通安装

- Filebeat安装部署

- ES数据定期删除

- 没数据问题排查思路

- X Logstash的grok语法调试

- 慢查询sql

- 审计日志

- Elasticsearch性能优化

- APM监控

- SkyWalking介绍

- Zipkin,Pinpoint,SkyWalking三种服务链路监控组件分析

- 服务端部署

- 客户端部署

- 日志清理

- Metrics监控

- 二进制包部署

- docker部署

- docker安装各组件监控

- Grafana仪表盘和告警配置

- JMeter压力测试工具

- 使用说明

- 分布式事务

- TX-LCN(同步)

- X SEATA(同步)

- X RocketMQ(异步)

- 消息队列

- RocketMQ

- RocketMQ安装部署

- RocketMQ常见异常处理

- SpringCloud-Stream

- RabbitMQ

- Redis

- 单机安装

- 主从复制

- 主从复制+哨兵

- cluster集群

- 持久化方案

- MySQL

- 单机安装

- 主从复制

- 主从切换

- 主主复制

- 高可用

- 分表分库

- Canal数据库日志解析消费

- Canal安装

- 实时同步数据到ElasticSearch

- FastDFS

- docker安装

- centos安装

- 项目管理系统

- 禅道

- 111