# 在 PagerDuty 迁移到 EC2 中的 XtraDB 群集

> 原文: [http://highscalability.com/blog/2014/6/16/migrating-to-xtradb-cluster-in-ec2-at-pagerduty.html](http://highscalability.com/blog/2014/6/16/migrating-to-xtradb-cluster-in-ec2-at-pagerduty.html)

*这是软件通才 [Doug Barth](https://twitter.com/dougbarth) 的来宾帖子,他目前发现自己在 [PagerDuty](https://www.pagerduty.com/) 从事运营工作。 在加入 PagerDuty 之前,他曾在芝加哥的 Signal 和在线旅游公司 Orbitz 任职。*

大约六个月前,PagerDuty 将其生产 MySQL 数据库切换为在 EC2 内部运行的 [XtraDB 群集](http://www.percona.com/software/percona-xtradb-cluster) 。 这是我们为什么以及如何进行更改的故事。

## 在之前的数据库外观

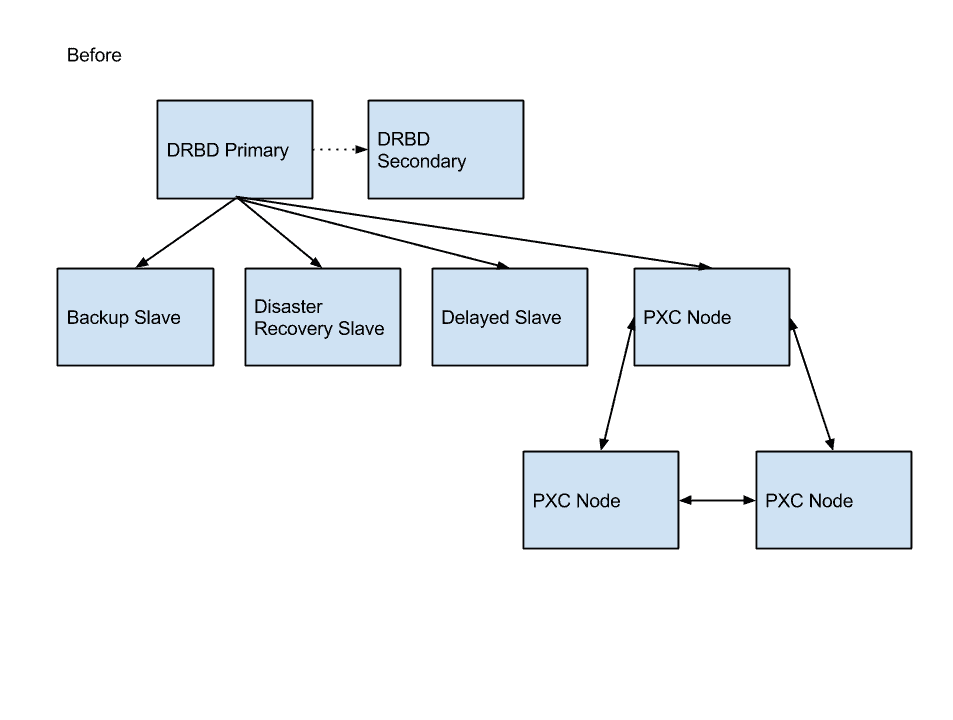

PagerDuty 的 MySQL 数据库是相当典型的部署。 我们有:

* 一对 Percona 服务器将数据写入支持 [DRBD](http://www.drbd.org/) 的卷。

* 支持 DRBD 卷的主服务器和辅助服务器的 EBS 磁盘。

* 生产数据库的两个同步副本。 (如果主服务器发生故障,我们希望能够快速切换到辅助服务器而不丢失任何数据。)

* 许多异步复制从属服务器,用于灾难恢复,备份和意外修改恢复。

## 旧设置出现问题

我们的数据库设置已经为我们服务了好几年,但是它提供的故障转移架构没有达到我们的可靠性目标。 另外,更改主机很麻烦:要从一台 DRBD 主机切换到另一台主机,我们必须在主服务器上停止 MySQL,卸载 DRBD 卷,将辅助服务器更改为主服务器状态,在该辅助服务器上安装该卷并启动 MySQL。 该设置需要停机-并且一旦 MySQL 在新服务器上启动并运行,我们就有了一个冷缓冲池,需要在应用程序性能恢复正常之前进行预热。

我们尝试使用 Percona 的 buffer-pool-restore 功能来缩短停机时间,但是我们的缓冲池太大了。 我们发现,恢复保存的缓冲池页面使用的系统资源要比缓慢处理传入请求的流量要多。

另一个问题:如果发生计划外的翻转,我们的异步奴隶将无法恢复。 我们将 binlog 存储在单独的,非 DRBD 支持的磁盘上,并禁用了 sync_binlog(由于引入了性能上的损失)。 这种设置意味着我们需要在计划外翻转之后从备份中还原异步从属服务器。

## 我们喜欢 XtraDB 群集

关于 XtraDB Cluster 的一些事情很突出。

* 不用拥有主动和被动服务器对,我们可以让 三个 实时服务器在彼此之间同步复制更改。 这将使我们能够更快地移动连接。

* 由于 XtraDB 群集是多主服务器,因此它使我们可以将流量发送到多台服务器,从而确保每台服务器始终具有暖缓冲区。 在 XtraDB 群集中,异步从属服务器可以将任何节点用作主服务器,并且可以在节点之间移动而不会破坏复制流。

* 群集的自动节点配置非常适合我们现有的自动化。 配置新节点后,我们要做的就是提供另一个节点的地址-新节点将自动接收数据集的副本(并在同步后加入集群)。

## 我们准备了什么

为 XtraDB Cluster 准备我们的应用程序确实涉及一些新的约束。 其中一些是简单的 MySQL 调整,大部分对应用程序逻辑是隐藏的,而另一些则是更基本的更改。

在 MySQL 方面:

* 我们需要确保仅使用具有主键的 InnoDB 表。

* 我们必须确保我们的应用程序不依赖于启用的查询缓存(因为集群不支持它)。

* 我们必须从基于语句的复制切换到基于行的复制。

除了这些 MySQL 配置更改(我们能够在 DRBD 服务器端隔离测试)之外,还需要更改应用程序逻辑:

* 我们需要使用分布式锁定机制,因为 MySQL 锁定(例如 SELECT FOR UPDATE 语句)对于群集节点而言是本地的。

* 因此,我们用 [Zookeeper](http://zookeeper.apache.org/) 锁替换了我们的 MySQL 锁(Zookeeper 已在该系统的其他部分中用于该目的)。

* 考虑到需要将写入集同步发送到所有节点这一事实,我们更改了进行较大更改的作业(通常是存档作业)的逻辑,以使用许多较小的事务而不是一个较大的事务。

## 我们如何处理架构变更

模式更改在 XtraDB 群集中尤其重要。 有两个选项可用于控制如何在集群中应用架构更改:总订单隔离(TOI)和滚动架构升级(RSU)。

RSU 允许您单独升级每个节点,在 DDL 语句运行时从群集中取消该节点的同步,然后重新加入群集。 但是这种方法可能会带来不稳定性-RSU 无法避免大型表上的架构更改带来的操作问题(因为它会在 DDL 语句完成之前将写集缓冲在内存中)。

相比之下, TOI 在所有 集群节点上同时对 应用模式升级,阻塞集群直到更改完成。 我们决定将 TOI 与 Percona 的在线模式更改工具(pt-online-schema-change)一起使用。 它确保任何阻塞操作都很快,因此不会阻塞群集。

## 迁移过程

建立了 XtraDB Cluster 引入的约束后,我们开始了推广过程。

首先,我们在生产中建立了一个集群,作为现有 DRBD 数据库的从属。 通过使该群集在生产环境中运行并接收所有写入流量,我们可以开始了解它在实际生产负载下的行为。 我们还设置了指标收集和仪表板来关注集群。

与此同时,我们花了一些时间对测试集群进行负载测试,以量化其相对于现有 DRBD 设置的性能。

运行这些基准测试使我们发现,必须对一些 MySQL 配置进行调整才能获得我们一直喜欢的性能水平:

* 将 innodb_flush_log_at_trx_commit 设置为 0 或 2 可获得最佳写入性能(相反,将其设置为 1,则将测试可扩展性限制为只能在我们的测试 VM 上使用 4 个线程)。 由于所有更改都被复制到 3 个节点,因此即使出现单个节点的磁盘一致性宽松的情况,我们也不会丢失任何数据。

* 需要一个大的 innodb_log_file_size 值。 我们最终为生产服务器提供了 1GB 的文件。

在让我们感到满意的是 XtraDB Cluster 能够处理我们的生产负荷之后,我们开始了将其移入生产用途的过程。

首先将所有测试环境切换到群集设置(并针对它们运行负载和故障测试)。 如果集群挂起,我们需要一种方法来快速将我们的系统重新配置为回退到单节点集群。 我们编写了该过程的脚本,并在负载下对其进行了测试。

实际上,将生产服务器移动到集群是一个多步骤的过程。 我们已经将生产集群设置为现有 DRBD 服务器的从属服务器,因此我们站起来并从属另一对 DRBD。 (这台 DRBD 服务器在那里,以防万一切换出现严重错误,我们需要退回到基于 DRBD 的解决方案,幸好我们最终不必这样做。)

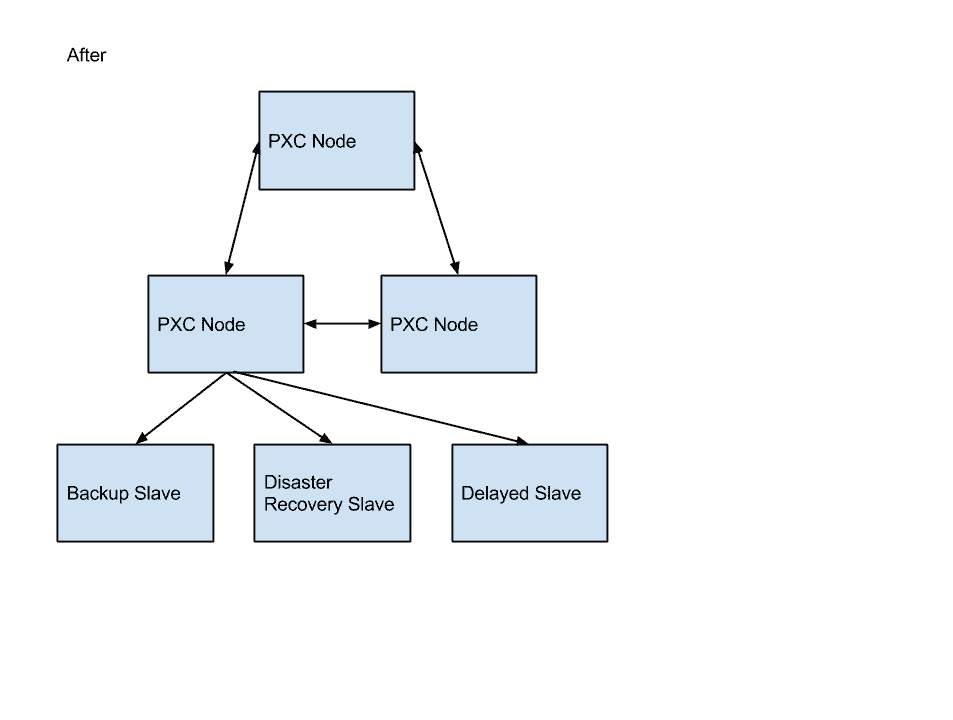

然后,我们将其余的异步从属设备(灾难恢复,备份等)移到了 XtraDB 集群后面。 那些奴隶坐在 XtraDB 集群后面,我们执行了正常的奴隶升级过程,将生产流量转移到新系统。

## 实际效果:收益

经过六个多月的生产使用,我们发现在 XtraDB 群集上运行有很多好处:

* 我们已经成功执行了生产集群的滚动重启和升级,而没有停止生产流量。

* 我们已经使用 pt-online-schema-change 在生产系统上执行了模式修改。

* 我们已经优化了如何处理写冲突。 XtraDB Cluster 在遇到冲突时会返回死锁错误-即使使用 pt-online-schema-change 执行快速 DDL 语句时也是如此。 冲突导致我们的应用服务器返回 503 响应,负载平衡层将捕获该响应。 负载平衡器随后将在另一台服务器上重试该请求。

## 现实世界的表现:烦恼

在此过程中,我们还发现了一些令人沮丧的问题:

* 某些集群的关键状态计数器是有状态的,这意味着它们在运行“ SHOW GLOBAL STATUS”后重置为零。 这使得很难监视系统中的关键计数器(例如流量控制),这些计数器很少增加,但对于了解系统的行为至关重要。 (但是,此问题已在 XtraDB Cluster 5.6 使用的 Galera 3.x 中修复。)

* ActiveRecord 的 MySQL 适配器隐藏了事务语句引发的异常,这些异常在发生写入集冲突时发生。 (此错误已在 Rails 4.1 中修复了 [。)](https://github.com/rails/rails/pull/12779)

* 我们还有很多工作要做,以解决服务器不正常的问题。 当前,我们的应用程序服务器连接到本地 HAproxy 实例,该实例将其连接转发到单个群集节点。 为了进行计划内的维护,我们在将流量完全分配给另一个群集节点之前,先将其缓慢释放到另一个群集节点以对其缓冲池进行预热。 将来,我们计划切换到完全多主机设置,以确保所有节点都具有热缓冲池。

很棒的帖子!

出于好奇,您是否发现具有 RBR 的集群提高了总体交易吞吐量? 您有可衡量的性能提升吗?

在查看 pt-online-schema-change 时,看来基于行的复制格式可能存在一些问题,尤其是在涉及触发器时(pt-osc 用于确保将更改写入新的临时表) 。 这是您必须处理的事情吗?

http://dev.mysql.com/doc/refman/5.5/en/replication-features-triggers.html

#1221372 如果服务器是基于行的复制中的从服务器

,则 pt-online-schema-change 应该会出错

https://bugs.launchpad.net/percona-toolkit/+bug/1221372

#1225577 pt-online-schema-change 可以静默删除行

https://bugs.launchpad.net/percona-toolkit/+bug/1225577

对于使用 pxc 的人来说,架构更新过程是什么样的?

问候。

集群中有多少数据(大致数字)? 我正在尝试将数据迁移到具有非常大的表的类似设置(大约 60 GB)中,并始终使用临时空间来打不同类型的障碍,并且在使用 mysqldumps 时集群不响应。 旧设置包含一个相当旧的 MySQL 版本。

香港专业教育学院

在为群集提供生产写入流量之前,我们仅对群集运行人为基准。 这些基准测试表明群集的性能与独立服务器一样,但应注意,sysbench 不会强调 RBR 与 SBR 的局限性。 (在单个事务中修改的行数很大)

因为我们的表都没有使用触发器,所以我们不需要处理任何触发器问题。 如果您在表上定义了触发器,则 pt-osc 将不起作用。 错误#1221372 不会影响我们,因为我们总是在主服务器上运行 pt-osc。

根据操作类型的不同,我们的架构升级会有所不同。 使用 Rails 迁移运行创建/删除表。 Alter 表是使用 pt-osc 运行的,我们手动插入 Rails 迁移行以将该迁移标记为完成。

什么,

我们的数据库有几百个 GB,表的大小各不相同(几兆最大> 100 GB)。 我还没有遇到任何有关临时空间的问题。 对于 mysqldump,也许您遇到流控制问题? 如果让 mysqldump 针对群集节点运行并且执行 FTWRL,则由于该节点无法提交挂起的写集,因此将迅速启动流控制。

如果要从群集节点提取备份,则需要处理该问题。 您可以在备份期间将节点从群集中取消同步,切换到另一个备份系统(如 xtrabackup),或使用事务进行一致的备份(仅需要 InnoDB 表)。 对于我们来说,我们有一个专用于备份的主机,它是集群的异步从机。 这样,备份过程带来的任何额外负担都不会影响我们的生产集群。

希望有帮助!

Mika,

我们正在运行一个非常相似的系统。 从 Doug 的描述中,听起来就像他们遵循了 PXC“参考体系结构”一样。 对我们来说,无论数据集大小如何,它都可以完美地工作。 一些现成的 Web 应用程序不能很好地与 PXC 配合使用,并且其中的大多数约束已在 OP 中列出。 我想在几点上进行扩展:

1-最新版本支持“更多”查询缓存,并且可以在启动配置中对其进行配置。 我们通过在 MySQL 进程启动后让操作员将 QC 大小设置为非零来解决早期的限制。

2-临时 MyISAM 表不复制。 当 DDL 指向其他表时,这将导致在其他节点上记录错误。 它还可以防止依赖临时表的应用程序扩展到单个节点之外。

3-编码不正确的应用程序可能会在群集上遇到认证错误(冲突),并且不会重试该语句。 可以将自动提交配置为对依赖它的应用程序自动重试。

InnoDB 上的 4- FULLTEXT 索引仅在 5.6 上受支持。 但是 5.6 对我来说似乎还不完全成熟-从 PXC 版本中已修复的错误数量来看。 但是至少 Percona 似乎在努力工作。

有一个仅在 5.6 中修复的 bug 击中了我们,但它本身表现为在群集的滚动更新期间 mysql 进程崩溃,因此该更新仅在零停机时间内回滚。 Percona 很快就解决了这个问题,即使我们不是付费客户,我也非常满意他们的沟通(可以为从事 PXC 工作的人员找到联系信息)。

要回答您的问题(部分是这样):Percona 创建了一个出色的工具“ XtraBackup”,可以进行在线备份。 在体验了 XtraBackup 之后,真的没有回过 mysqldump 了。 看看,确实没有与该工具进行备份的比较。

道格,

如果使用 PHP,是否尝试在客户端主机上使用 mysqlnd_ms 而不是 HAProxy? 关于 mysqlnd_ms 的任何评论? 看起来很有趣,但是我不确定我是否愿意放弃客户端主机上 HAProxy 提供的稳定性,控制性和可见性。

-V

我们在一个国家/地区中确实有一个 percona Xtra 数据库集群(Master-Master -Master)设置,而我们希望在其他国家/地区中设置灾难恢复设置。请提出一种最佳的实现方法吗? 提前致谢!

- LiveJournal 体系结构

- mixi.jp 体系结构

- 友谊建筑

- FeedBurner 体系结构

- GoogleTalk 架构

- ThemBid 架构

- 使用 Amazon 服务以 100 美元的价格构建无限可扩展的基础架构

- TypePad 建筑

- 维基媒体架构

- Joost 网络架构

- 亚马逊建筑

- Fotolog 扩展成功的秘诀

- 普恩斯的教训-早期

- 论文:Wikipedia 的站点内部,配置,代码示例和管理问题

- 扩大早期创业规模

- Feedblendr 架构-使用 EC2 进行扩展

- Slashdot Architecture-互联网的老人如何学会扩展

- Flickr 架构

- Tailrank 架构-了解如何在整个徽标范围内跟踪模因

- Ruby on Rails 如何在 550k 网页浏览中幸存

- Mailinator 架构

- Rackspace 现在如何使用 MapReduce 和 Hadoop 查询 TB 的数据

- Yandex 架构

- YouTube 架构

- Skype 计划 PostgreSQL 扩展到 10 亿用户

- 易趣建筑

- FaceStat 的祸根与智慧赢得了胜利

- Flickr 的联合会:每天进行数十亿次查询

- EVE 在线架构

- Notify.me 体系结构-同步性

- Google 架构

- 第二人生架构-网格

- MySpace 体系结构

- 扩展 Digg 和其他 Web 应用程序

- Digg 建筑

- 在 Amazon EC2 中部署大规模基础架构的六个经验教训

- Wolfram | Alpha 建筑

- 为什么 Facebook,Digg 和 Twitter 很难扩展?

- 全球范围扩展的 10 个 eBay 秘密

- BuddyPoke 如何使用 Google App Engine 在 Facebook 上扩展

- 《 FarmVille》如何扩展以每月收获 7500 万玩家

- Twitter 计划分析 1000 亿条推文

- MySpace 如何与 100 万个并发用户一起测试其实时站点

- FarmVille 如何扩展-后续

- Justin.tv 的实时视频广播架构

- 策略:缓存 404 在服务器时间上节省了洋葱 66%

- Poppen.de 建筑

- MocoSpace Architecture-一个月有 30 亿个移动页面浏览量

- Sify.com 体系结构-每秒 3900 个请求的门户

- 每月将 Reddit 打造为 2.7 亿页面浏览量时汲取的 7 个教训

- Playfish 的社交游戏架构-每月有 5000 万用户并且不断增长

- 扩展 BBC iPlayer 的 6 种策略

- Facebook 的新实时消息系统:HBase 每月可存储 135 亿条消息

- Pinboard.in Architecture-付费玩以保持系统小巧

- BankSimple 迷你架构-使用下一代工具链

- Riak 的 Bitcask-用于快速键/值数据的日志结构哈希表

- Mollom 体系结构-每秒以 100 个请求杀死超过 3.73 亿个垃圾邮件

- Wordnik-MongoDB 和 Scala 上每天有 1000 万个 API 请求

- Node.js 成为堆栈的一部分了吗? SimpleGeo 说是的。

- 堆栈溢出体系结构更新-现在每月有 9500 万页面浏览量

- Medialets 体系结构-击败艰巨的移动设备数据

- Facebook 的新实时分析系统:HBase 每天处理 200 亿个事件

- Microsoft Stack 是否杀死了 MySpace?

- Viddler Architecture-每天嵌入 700 万个和 1500 Req / Sec 高峰

- Facebook:用于扩展数十亿条消息的示例规范架构

- Evernote Architecture-每天有 900 万用户和 1.5 亿个请求

- TripAdvisor 的短

- TripAdvisor 架构-4,000 万访客,200M 动态页面浏览,30TB 数据

- ATMCash 利用虚拟化实现安全性-不变性和还原

- Google+是使用您也可以使用的工具构建的:闭包,Java Servlet,JavaScript,BigTable,Colossus,快速周转

- 新的文物建筑-每天收集 20 亿多个指标

- Peecho Architecture-鞋带上的可扩展性

- 标记式架构-扩展到 1 亿用户,1000 台服务器和 50 亿个页面视图

- 论文:Akamai 网络-70 个国家/地区的 61,000 台服务器,1,000 个网络

- 策略:在 S3 或 GitHub 上运行可扩展,可用且廉价的静态站点

- Pud 是反堆栈-Windows,CFML,Dropbox,Xeround,JungleDisk,ELB

- 用于扩展 Turntable.fm 和 Labmeeting 的数百万用户的 17 种技术

- StackExchange 体系结构更新-平稳运行,Amazon 4x 更昂贵

- DataSift 体系结构:每秒进行 120,000 条推文的实时数据挖掘

- Instagram 架构:1400 万用户,1 TB 的照片,数百个实例,数十种技术

- PlentyOfFish 更新-每月 60 亿次浏览量和 320 亿张图片

- Etsy Saga:从筒仓到开心到一个月的浏览量达到数十亿

- 数据范围项目-6PB 存储,500GBytes / sec 顺序 IO,20M IOPS,130TFlops

- 99designs 的设计-数以千万计的综合浏览量

- Tumblr Architecture-150 亿页面浏览量一个月,比 Twitter 更难扩展

- Berkeley DB 体系结构-NoSQL 很酷之前的 NoSQL

- Pixable Architecture-每天对 2000 万张照片进行爬网,分析和排名

- LinkedIn:使用 Databus 创建低延迟更改数据捕获系统

- 在 30 分钟内进行 7 年的 YouTube 可扩展性课程

- YouPorn-每天定位 2 亿次观看

- Instagram 架构更新:Instagram 有何新功能?

- 搜索技术剖析:blekko 的 NoSQL 数据库

- Pinterest 体系结构更新-1800 万访问者,增长 10 倍,拥有 12 名员工,410 TB 数据

- 搜索技术剖析:使用组合器爬行

- iDoneThis-从头开始扩展基于电子邮件的应用程序

- StubHub 体系结构:全球最大的票务市场背后的惊人复杂性

- FictionPress:在网络上发布 600 万本小说

- Cinchcast 体系结构-每天产生 1,500 小时的音频

- 棱柱架构-使用社交网络上的机器学习来弄清您应该在网络上阅读的内容

- 棱镜更新:基于文档和用户的机器学习

- Zoosk-实时通信背后的工程

- WordPress.com 使用 NGINX 服务 70,000 req / sec 和超过 15 Gbit / sec 的流量

- 史诗般的 TripAdvisor 更新:为什么不在云上运行? 盛大的实验

- UltraDNS 如何处理数十万个区域和数千万条记录

- 更简单,更便宜,更快:Playtomic 从.NET 迁移到 Node 和 Heroku

- Spanner-关于程序员使用 NoSQL 规模的 SQL 语义构建应用程序

- BigData 使用 Erlang,C 和 Lisp 对抗移动数据海啸

- 分析数十亿笔信用卡交易并在云中提供低延迟的见解

- MongoDB 和 GridFS 用于内部和内部数据中心数据复制

- 每天处理 1 亿个像素-少量竞争会导致大规模问题

- DuckDuckGo 体系结构-每天进行 100 万次深度搜索并不断增长

- SongPop 在 GAE 上可扩展至 100 万活跃用户,表明 PaaS 未通过

- Iron.io 从 Ruby 迁移到 Go:减少了 28 台服务器并避免了巨大的 Clusterf ** ks

- 可汗学院支票簿每月在 GAE 上扩展至 600 万用户

- 在破坏之前先检查自己-鳄梨的建筑演进的 5 个早期阶段

- 缩放 Pinterest-两年内每月从 0 到十亿的页面浏览量

- Facebook 的网络秘密

- 神话:埃里克·布鲁尔(Eric Brewer)谈银行为什么不是碱-可用性就是收入

- 一千万个并发连接的秘密-内核是问题,而不是解决方案

- GOV.UK-不是你父亲的书库

- 缩放邮箱-在 6 周内从 0 到 100 万用户,每天 1 亿条消息

- 在 Yelp 上利用云计算-每月访问量为 1.02 亿,评论量为 3900 万

- 每台服务器将 PHP 扩展到 30,000 个并发用户的 5 条 Rockin'Tips

- Twitter 的架构用于在 5 秒内处理 1.5 亿活跃用户,300K QPS,22 MB / S Firehose 以及发送推文

- Salesforce Architecture-他们每天如何处理 13 亿笔交易

- 扩大流量的设计决策

- ESPN 的架构规模-每秒以 100,000 Duh Nuh Nuhs 运行

- 如何制作无限可扩展的关系数据库管理系统(RDBMS)

- Bazaarvoice 的架构每月发展到 500M 唯一用户

- HipChat 如何使用 ElasticSearch 和 Redis 存储和索引数十亿条消息

- NYTimes 架构:无头,无主控,无单点故障

- 接下来的大型声音如何使用 Hadoop 数据版本控制系统跟踪万亿首歌曲的播放,喜欢和更多内容

- Google 如何备份 Internet 和数十亿字节的其他数据

- 从 HackerEarth 用 Apache 扩展 Python 和 Django 的 13 个简单技巧

- AOL.com 体系结构如何发展到 99.999%的可用性,每天 800 万的访问者和每秒 200,000 个请求

- Facebook 以 190 亿美元的价格收购了 WhatsApp 体系结构

- 使用 AWS,Scala,Akka,Play,MongoDB 和 Elasticsearch 构建社交音乐服务

- 大,小,热还是冷-条带,Tapad,Etsy 和 Square 的健壮数据管道示例

- WhatsApp 如何每秒吸引近 5 亿用户,11,000 内核和 7,000 万条消息

- Disqus 如何以每秒 165K 的消息和小于 0.2 秒的延迟进行实时处理

- 关于 Disqus 的更新:它仍然是实时的,但是 Go 摧毁了 Python

- 关于 Wayback 机器如何在银河系中存储比明星更多的页面的简短说明

- 在 PagerDuty 迁移到 EC2 中的 XtraDB 群集

- 扩展世界杯-Gambify 如何与 2 人组成的团队一起运行大型移动投注应用程序

- 一点点:建立一个可处理每月 60 亿次点击的分布式系统的经验教训

- StackOverflow 更新:一个月有 5.6 亿次网页浏览,25 台服务器,而这一切都与性能有关

- Tumblr:哈希处理每秒 23,000 个博客请求的方式

- 使用 HAProxy,PHP,Redis 和 MySQL 处理 10 亿个请求的简便方法来构建成长型启动架构

- MixRadio 体系结构-兼顾各种服务

- Twitter 如何使用 Redis 进行扩展-105TB RAM,39MM QPS,10,000 多个实例

- 正确处理事情:通过即时重放查看集中式系统与分散式系统

- Instagram 提高了其应用程序的性能。 这是如何做。

- Clay.io 如何使用 AWS,Docker,HAProxy 和 Lots 建立其 10 倍架构

- 英雄联盟如何将聊天扩大到 7000 万玩家-需要很多小兵。

- Wix 的 Nifty Architecture 技巧-大规模构建发布平台

- Aeron:我们真的需要另一个消息传递系统吗?

- 机器:惠普基于忆阻器的新型数据中心规模计算机-一切仍在变化

- AWS 的惊人规模及其对云的未来意味着什么

- Vinted 体系结构:每天部署数百次,以保持繁忙的门户稳定

- 将 Kim Kardashian 扩展到 1 亿个页面

- HappyPancake:建立简单可扩展基金会的回顾

- 阿尔及利亚分布式搜索网络的体系结构

- AppLovin:通过每天处理 300 亿个请求向全球移动消费者进行营销

- Swiftype 如何以及为何从 EC2 迁移到真实硬件

- 我们如何扩展 VividCortex 的后端系统

- Appknox 架构-从 AWS 切换到 Google Cloud

- 阿尔及利亚通往全球 API 的愤怒之路

- 阿尔及利亚通往全球 API 步骤的愤怒之路第 2 部分

- 为社交产品设计后端

- 阿尔及利亚通往全球 API 第 3 部分的愤怒之路

- Google 如何创造只有他们才能创造的惊人的数据中心网络

- Autodesk 如何在 Mesos 上实施可扩展事件

- 构建全球分布式,关键任务应用程序:Trenches 部分的经验教训 1

- 构建全球分布式,关键任务应用程序:Trenches 第 2 部分的经验教训

- 需要物联网吗? 这是美国一家主要公用事业公司从 550 万米以上收集电力数据的方式

- Uber 如何扩展其实时市场平台

- 优步变得非常规:使用司机电话作为备份数据中心

- 在不到五分钟的时间里,Facebook 如何告诉您的朋友您在灾难中很安全

- Zappos 的网站与 Amazon 集成后冻结了两年

- 为在现代时代构建可扩展的有状态服务提供依据

- 细分:使用 Docker,ECS 和 Terraform 重建基础架构

- 十年 IT 失败的五个教训

- Shopify 如何扩展以处理来自 Kanye West 和 Superbowl 的 Flash 销售

- 整个 Netflix 堆栈的 360 度视图

- Wistia 如何每小时处理数百万个请求并处理丰富的视频分析

- Google 和 eBay 关于构建微服务生态系统的深刻教训

- 无服务器启动-服务器崩溃!

- 在 Amazon AWS 上扩展至 1100 万以上用户的入门指南

- 为 David Guetta 建立无限可扩展的在线录制活动

- Tinder:最大的推荐引擎之一如何决定您接下来会看到谁?

- 如何使用微服务建立财产管理系统集成

- Egnyte 体系结构:构建和扩展多 PB 分布式系统的经验教训

- Zapier 如何自动化数十亿个工作流自动化任务的旅程

- Jeff Dean 在 Google 进行大规模深度学习

- 如今 Etsy 的架构是什么样的?

- 我们如何在 Mail.Ru Cloud 中实现视频播放器

- Twitter 如何每秒处理 3,000 张图像

- 每天可处理数百万个请求的图像优化技术

- Facebook 如何向 80 万同时观看者直播

- Google 如何针对行星级基础设施进行行星级工程设计?

- 为 Mail.Ru Group 的电子邮件服务实施反垃圾邮件的猫捉老鼠的故事,以及 Tarantool 与此相关的内容

- The Dollar Shave Club Architecture Unilever 以 10 亿美元的价格被收购

- Uber 如何使用 Mesos 和 Cassandra 跨多个数据中心每秒管理一百万个写入

- 从将 Uber 扩展到 2000 名工程师,1000 个服务和 8000 个 Git 存储库获得的经验教训

- QuickBooks 平台

- 美国大选期间城市飞艇如何扩展到 25 亿个通知

- Probot 的体系结构-我的 Slack 和 Messenger Bot 用于回答问题

- AdStage 从 Heroku 迁移到 AWS

- 为何将 Morningstar 迁移到云端:降低 97%的成本

- ButterCMS 体系结构:关键任务 API 每月可处理数百万个请求

- Netflix:按下 Play 会发生什么?

- ipdata 如何以每月 150 美元的价格为来自 10 个无限扩展的全球端点的 2500 万个 API 调用提供服务

- 每天为 1000 亿个事件赋予意义-Teads 的 Analytics(分析)管道

- Auth0 体系结构:在多个云提供商和地区中运行

- 从裸机到 Kubernetes

- Egnyte Architecture:构建和扩展多 PB 内容平台的经验教训

- 缩放原理

- TripleLift 如何建立 Adtech 数据管道每天处理数十亿个事件

- Tinder:最大的推荐引擎之一如何决定您接下来会看到谁?

- 如何使用微服务建立财产管理系统集成

- Egnyte 体系结构:构建和扩展多 PB 分布式系统的经验教训

- Zapier 如何自动化数十亿个工作流自动化任务的旅程

- Jeff Dean 在 Google 进行大规模深度学习

- 如今 Etsy 的架构是什么样的?

- 我们如何在 Mail.Ru Cloud 中实现视频播放器

- Twitter 如何每秒处理 3,000 张图像

- 每天可处理数百万个请求的图像优化技术

- Facebook 如何向 80 万同时观看者直播

- Google 如何针对行星级基础设施进行行星级工程设计?

- 为 Mail.Ru Group 的电子邮件服务实施反垃圾邮件的猫捉老鼠的故事,以及 Tarantool 与此相关的内容

- The Dollar Shave Club Architecture Unilever 以 10 亿美元的价格被收购

- Uber 如何使用 Mesos 和 Cassandra 跨多个数据中心每秒管理一百万个写入

- 从将 Uber 扩展到 2000 名工程师,1000 个服务和 8000 个 Git 存储库获得的经验教训

- QuickBooks 平台

- 美国大选期间城市飞艇如何扩展到 25 亿条通知

- Probot 的体系结构-我的 Slack 和 Messenger Bot 用于回答问题

- AdStage 从 Heroku 迁移到 AWS

- 为何将 Morningstar 迁移到云端:降低 97%的成本

- ButterCMS 体系结构:关键任务 API 每月可处理数百万个请求

- Netflix:按下 Play 会发生什么?

- ipdata 如何以每月 150 美元的价格为来自 10 个无限扩展的全球端点的 2500 万个 API 调用提供服务

- 每天为 1000 亿个事件赋予意义-Teads 的 Analytics(分析)管道

- Auth0 体系结构:在多个云提供商和地区中运行

- 从裸机到 Kubernetes

- Egnyte Architecture:构建和扩展多 PB 内容平台的经验教训