## PaddlePaddle

[Paddle Lite_飞桨-源于产业实践的开源深度学习平台](https://www.paddlepaddle.org.cn/paddle/paddlelite)

[英特尔 FPGA 部署示例-PaddlePaddle深度学习平台](https://www.paddlepaddle.org.cn/lite/v2.10/demo_guides/intel_fpga.html)

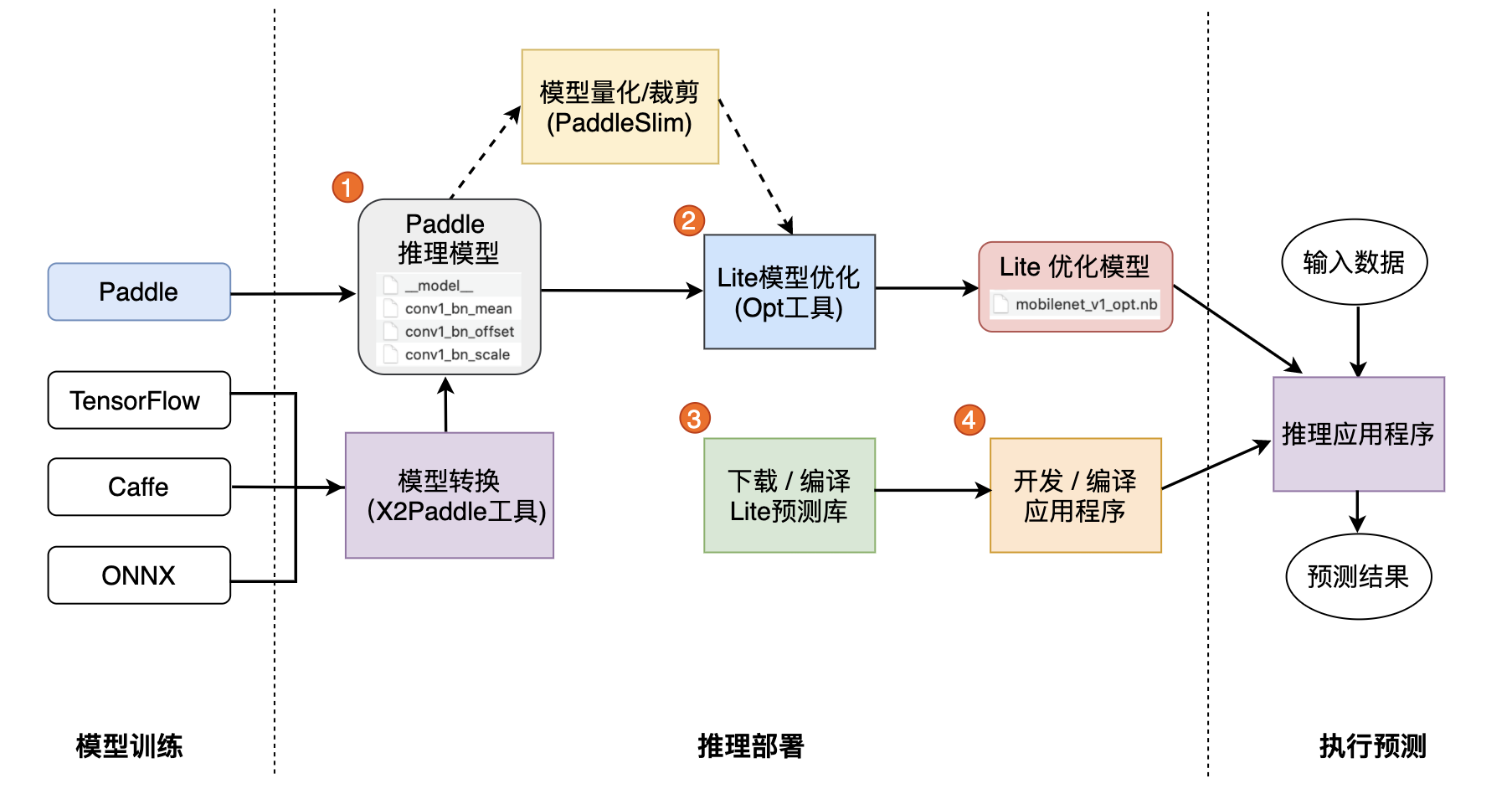

1. Lite 预编译库[下载](https://www.paddlepaddle.org.cn/lite/v2.10/quick_start/release_lib.html)

2. 安装 python预测库

~~~

pip install paddlelite==2.9

~~~

3. 通过模型可视化工具[Netron](https://github.com/lutzroeder/netron)打开文件夹下的__model__文件,查看模型结构。 https://netron.app/

4. 开发应用程序

~~~

https://www.paddlepaddle.org.cn/lite/v2.9/quick_start/python_demo.html

1. 声明`MobileConfig`,设置第二步优化后的模型文件路径,或选择从内存中加载模型

2. 创建`Predictor`,调用`CreatePaddlePredictor`接口,一行代码即可完成引擎初始化

3. 准备输入,通过`predictor->GetInput(i)`获取输入变量,并为其指定输入大小和输入值

4. 执行预测,只需要运行`predictor->Run()`一行代码,即可使用Lite框架完成预测执行

5. 获得输出,使用`predictor->GetOutput(i)`获取输出变量,并通过`data<T>`取得输出值

~~~

----

~~~

海云捷迅杯

一、杯赛题目:基于FPGA CNN加速器的SSD_MobileNetV1模型目标检测实现

二、参赛组别:A组、B组

三、设计任务:

1. 基于百度Paddle-lite v2.9框架①(必须)、海云捷迅自研CNN加速器(可选,也可以使用自己设计的加速器)(包含卷积、DW卷积、RELU、RELU6、量化算法,其中量化是把计算好的32位定点转为浮点再转为8位定点输出)。

2. 基于该加速器Linux驱动示例,可以看到数据重整的方法。根据算子运行位置(PS、PL)的不同,参照驱动示例来重新排列数据。

3. 基于VOC数据集进行训练。

4. 对模型在要求的设计指标内进行各种优化操作,包括剪枝、量化等。

5. 提出设计方案,实现并完成指定测试图片集的目标检测功能。

6. 基础部分60分(满足设计指标),附加部分40分(在满足设计指标的情况下,按照推理速度进行评分)。最后总分按两部分相加得到。

7. 备注:海云捷迅会提供(杯赛钉钉群内下载):

1) FPGA配置文件

2) CNN加速器相对应的Linux驱动示例

3) Paddle-lite v2.9①、SSD_MobileNetV1②(全精度版本) 的Demo程序;驱动示例;CNN加速器FPGA配置文件

四、设计指标:

1. 模型部署完成,能正确识别图片数据。

2. 帧率不低于2帧。

3. 精度不低于65%。

~~~

----

~~~

http://183.230.19.155:16789/s/bb7WcRHNq3Yq2wj

fpga@2022

~~~

- 开始

- 公益

- 更好的使用看云

- 推荐书单

- 优秀资源整理

- 技术文章写作规范

- SublimeText - 编码利器

- PSR-0/PSR-4命名标准

- php的多进程实验分析

- 高级PHP

- 进程

- 信号

- 事件

- IO模型

- 同步、异步

- socket

- Swoole

- PHP扩展

- Composer

- easyswoole

- php多线程

- 守护程序

- 文件锁

- s-socket

- aphp

- 队列&并发

- 队列

- 讲个故事

- 如何最大效率的问题

- 访问式的web服务(一)

- 访问式的web服务(二)

- 请求

- 浏览器访问阻塞问题

- Swoole

- 你必须理解的计算机核心概念 - 码农翻身

- CPU阿甘 - 码农翻身

- 异步通知,那我要怎么通知你啊?

- 实时操作系统

- 深入实时 Linux

- Redis 实现队列

- redis与队列

- 定时-时钟-阻塞

- 计算机的生命

- 多进程/多线程

- 进程通信

- 拜占庭将军问题深入探讨

- JAVA CAS原理深度分析

- 队列的思考

- 走进并发的世界

- 锁

- 事务笔记

- 并发问题带来的后果

- 为什么说乐观锁是安全的

- 内存锁与内存事务 - 刘小兵2014

- 加锁还是不加锁,这是一个问题 - 码农翻身

- 编程世界的那把锁 - 码农翻身

- 如何保证万无一失

- 传统事务与柔性事务

- 大白话搞懂什么是同步/异步/阻塞/非阻塞

- redis实现锁

- 浅谈mysql事务

- PHP异常

- php错误

- 文件加载

- 路由与伪静态

- URL模式之分析

- 字符串处理

- 正则表达式

- 数组合并与+

- 文件上传

- 常用验证与过滤

- 记录

- 趣图

- foreach需要注意的问题

- Discuz!笔记

- 程序设计思维

- 抽象与具体

- 配置

- 关于如何学习的思考

- 编程思维

- 谈编程

- 如何安全的修改对象

- 临时

- 临时笔记

- 透过问题看本质

- 程序后门

- 边界检查

- session

- 安全

- 王垠

- 第三方数据接口

- 验证码问题

- 还是少不了虚拟机

- 程序员如何谈恋爱

- 程序员为什么要一直改BUG,为什么不能一次性把代码写好?

- 碎碎念

- 算法

- 实用代码

- 相对私密与绝对私密

- 学习目标

- 随记

- 编程小知识

- foo

- 落盘

- URL编码的思考

- 字符编码

- Elasticsearch

- TCP-IP协议

- 碎碎念2

- Grafana

- EFK、ELK

- RPC

- 依赖注入

- 开发笔记

- 经纬度格式转换

- php时区问题

- 解决本地开发时调用远程AIP跨域问题

- 后期静态绑定

- 谈tp的跳转提示页面

- 无限分类问题

- 生成微缩图

- MVC名词

- MVC架构

- 也许模块不是唯一的答案

- 哈希算法

- 开发后台

- 软件设计架构

- mysql表字段设计

- 上传表如何设计

- 二开心得

- awesomes-tables

- 安全的代码部署

- 微信开发笔记

- 账户授权相关

- 小程序获取是否关注其公众号

- 支付相关

- 提交订单

- 微信支付笔记

- 支付接口笔记

- 支付中心开发

- 下单与支付

- 支付流程设计

- 订单与支付设计

- 敏感操作验证

- 排序设计

- 代码的运行环境

- 搜索关键字的显示处理

- 接口异步更新ip信息

- 图片处理

- 项目搭建

- 阅读文档的新方式

- mysql_insert_id并发问题思考

- 行锁注意事项

- 细节注意

- 如何处理用户的输入

- 不可见的字符

- 抽奖

- 时间处理

- 应用开发实战

- python 学习记录

- Scrapy 教程

- Playwright 教程

- stealth.min.js

- Selenium 教程

- requests 教程

- pyautogui 教程

- Flask 教程

- PyInstaller 教程

- 蜘蛛

- python 文档相似度验证

- thinkphp5.0数据库与模型的研究

- workerman进程管理

- workerman网络分析

- java学习记录

- docker

- 笔记

- kubernetes

- Kubernetes

- PaddlePaddle

- composer

- oneinstack

- 人工智能 AI

- 京东

- pc_detailpage_wareBusiness

- doc

- 电商网站设计

- iwebshop

- 商品规格分析

- 商品属性分析

- tpshop

- 商品规格分析

- 商品属性分析

- 电商表设计

- 设计记录

- 优惠券

- 生成唯一订单号

- 购物车技术

- 分类与类型

- 微信登录与绑定

- 京东到家库存系统架构设计

- crmeb

- 命名规范

- Nginx https配置

- 关于人工智能

- 从人的思考方式到二叉树

- 架构

- 今日有感

- 文章保存

- 安全背后: 浏览器是如何校验证书的

- 避不开的分布式事务

- devops自动化运维、部署、测试的最后一公里 —— ApiFox 云时代的接口管理工具

- 找到自己今生要做的事

- 自动化生活

- 开源与浆果

- Apifox: API 接口自动化测试指南